- 快召唤伙伴们来围观吧

- 微博 QQ QQ空间 贴吧

- 文档嵌入链接

- 复制

- 微信扫一扫分享

- 已成功复制到剪贴板

TiDB在Ping++金融聚合支付下的实践

展开查看详情

1 .TiDB在⾦金金融聚合⽀支付业务的实践

2 . 个⼈人简介 • 宋涛 • Ping++ DBA • 负责Ping++数据库相关⼯工作、数据库⾃自动化运维建设

3 . TiDB在Ping++⾦金金融聚合⽀支付业务的实践 • TiDB在Ping++的应⽤用场景分析 - OLAP:saas服务下实时数仓的⽀支撑 - HTAP:基于TiDB Docker的聚合⽀支付私有化部署⽅方案 • 关于TiDB的线上运维 - TiDB体系 - 业务零感知运维

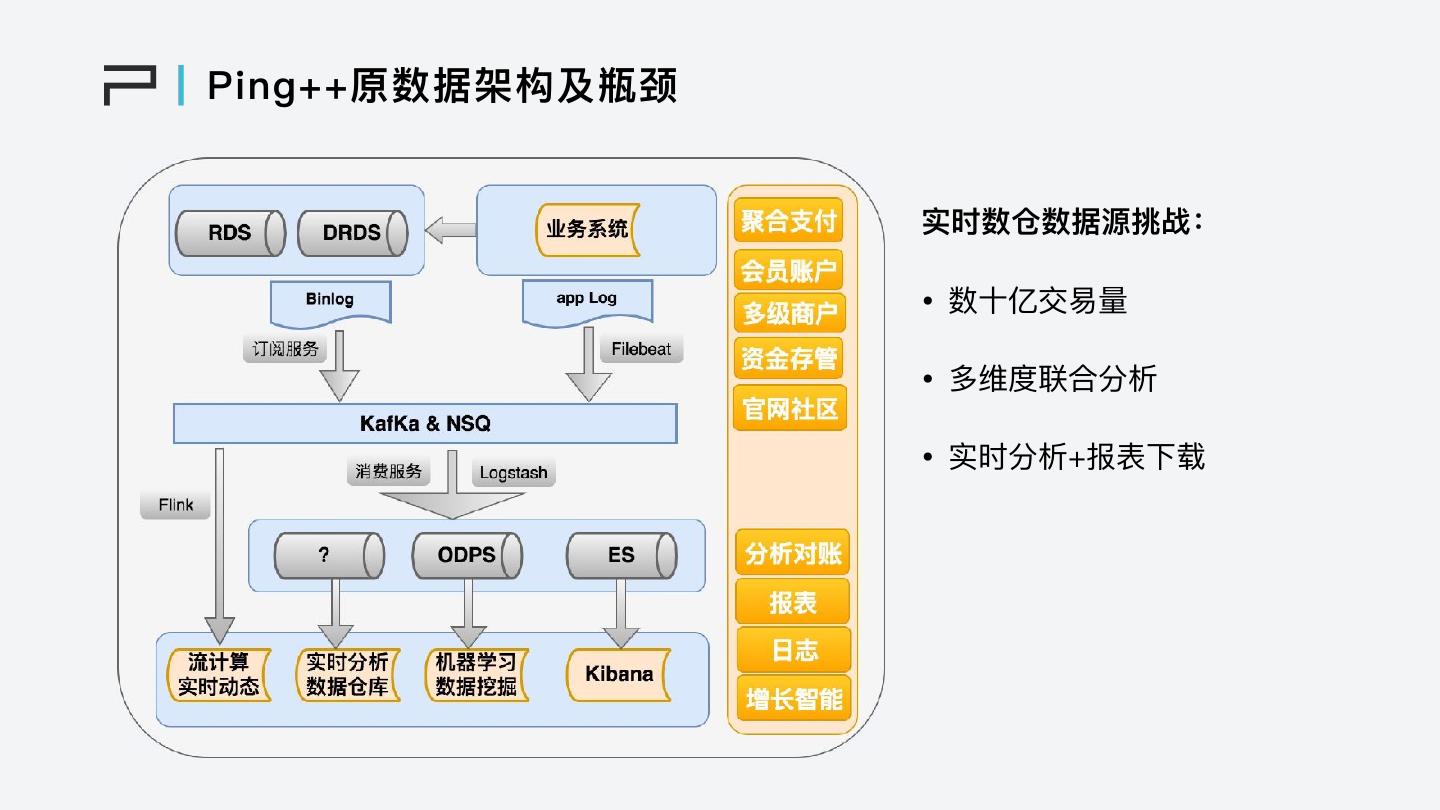

4 .Ping++原数据架构及瓶颈 实时数仓数据源挑战: • 数⼗十亿交易易量量 • 多维度联合分析 • 实时分析+报表下载

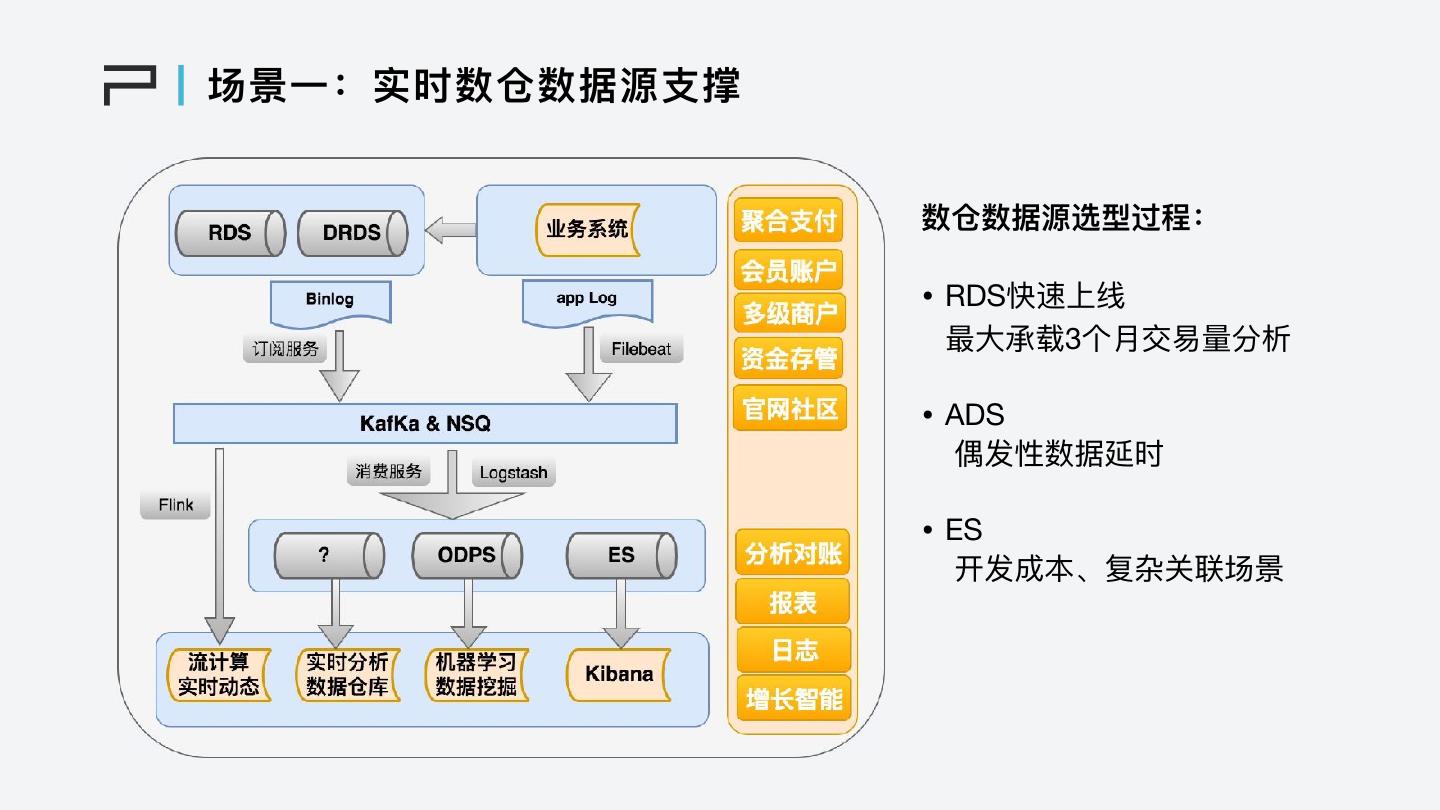

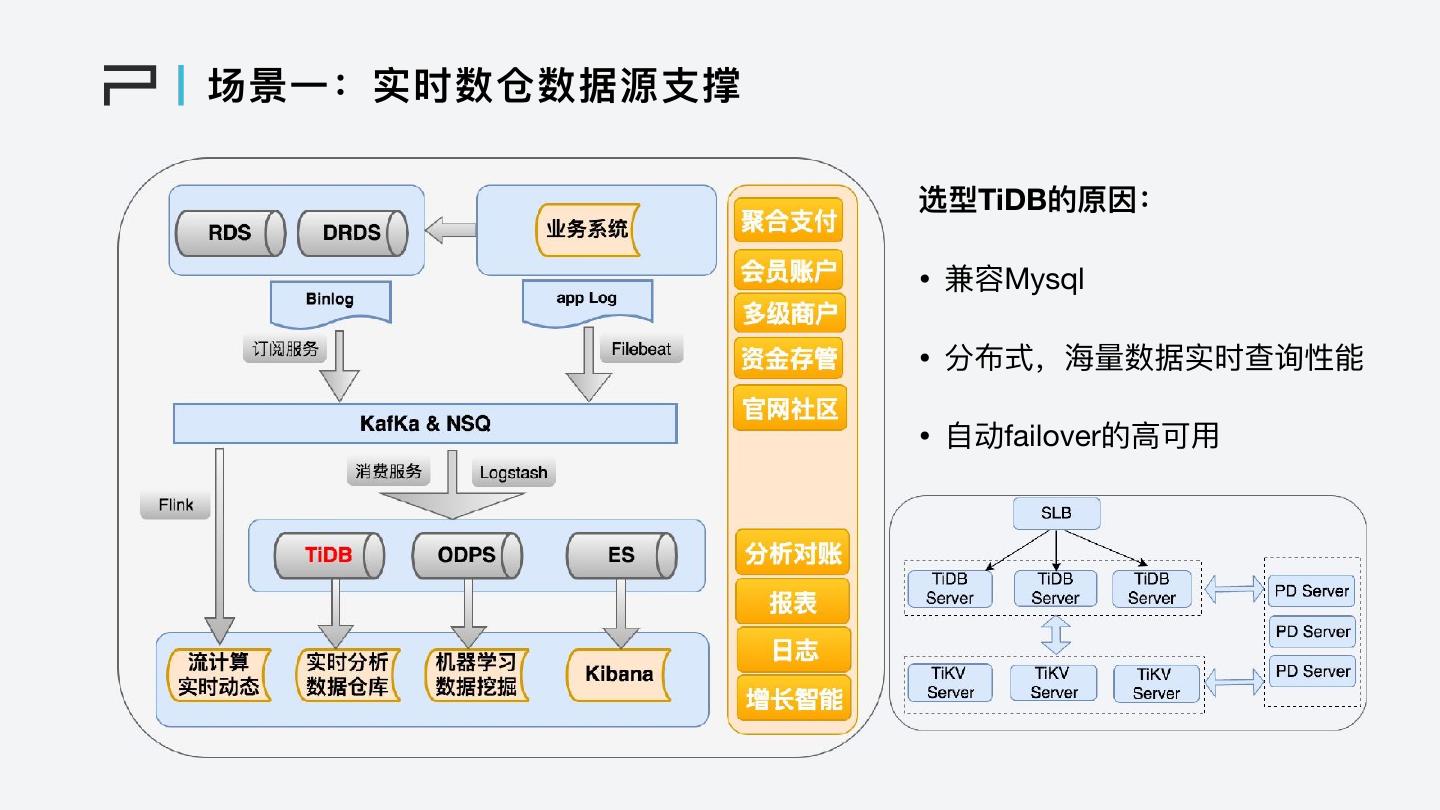

5 .场景⼀一:实时数仓数据源⽀支撑 数仓数据源选型过程: • RDS快速上线 最⼤大承载3个⽉月交易易量量分析 • ADS 偶发性数据延时 • ES 开发成本、复杂关联场景

6 .场景⼀一:实时数仓数据源⽀支撑 选型TiDB的原因: • 兼容Mysql • 分布式,海海量量数据实时查询性能 • ⾃自动failover的⾼高可⽤用

7 . 场景⼆二:聚合⽀支付私有化部署⽅方案 服务私有化部署的数据库要求: • 脱离云产品:DRDS • oltp+olap • 海海量量交易易下的单表性能:分库分表? • ⾼高可⽤用:MHA?Innodb Cluster? • 监控、运维⽅方式简单⾼高效

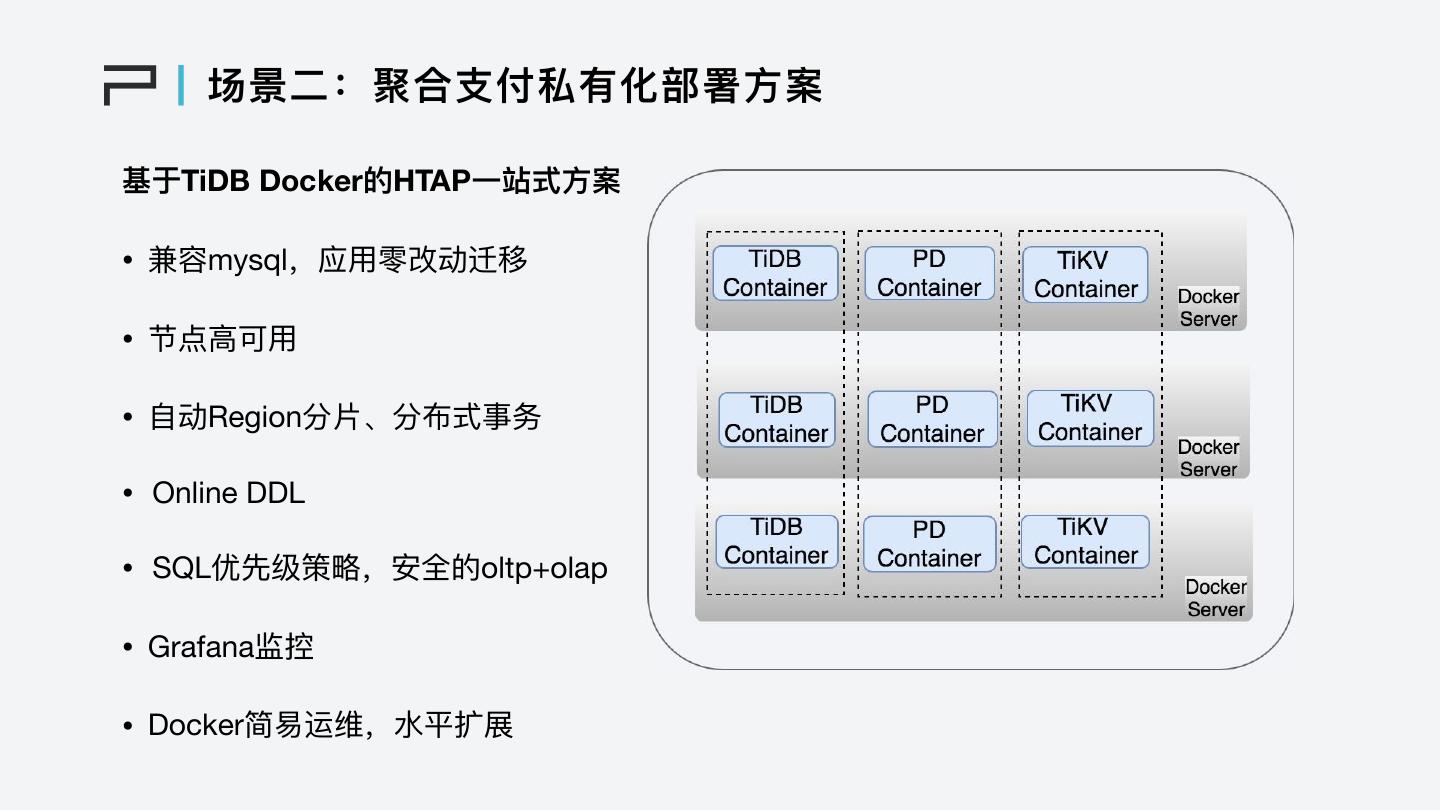

8 . 场景⼆二:聚合⽀支付私有化部署⽅方案 基于TiDB Docker的HTAP⼀一站式⽅方案 • 兼容mysql,应⽤用零改动迁移 • 节点⾼高可⽤用 • ⾃自动Region分⽚片、分布式事务 • Online DDL • SQL优先级策略略,安全的oltp+olap • Grafana监控 • Docker简易易运维,⽔水平扩展

9 . TiDB线上运维 • TiDB体系

10 . TiDB线上运维 TiDB的业务零感知运维 • ⾃自动运维:TiDB升级、节点扩展/下线 TiDB-Ansible • ⼿手动运维:升级磁盘、磁盘扩容、数据迁移、⽹网络升级、服务器器重启等 - TiDB节点: 负载均衡层权重—>stop start—>负载均衡层权重 - PD节点: member leader transfer—>member delete—>stop rm member_data —>配置“join”—>start - TiKV节点: store weight、add evict-leader-scheduler—>stop start—>store weight、 remove evict-leader-scheduler

11 .Thanks